Bericht von der SEO CAMPIXX 2021

Am 26. und 27. August 2021 waren wir bei der SEO CAMPIXX 2021 Summer Edition in Berlin dabei. Es gab wieder eine Fülle hochinteressanter Vorträge. Wir fassen die aus unserer Sicht spannendsten Sessions und wichtigsten Erkenntnisse zusammen.

Zahlen und Fakten zur SEO CAMPIXX 2021

Unter dem Namen CAMPIXX organisiert die Berliner SEO-Agentur Sumago Events zu unterschiedlichen Themenschwerpunkten im Bereich Marketing. Eines der zentralen Themenfelder dieser Veranstaltungsreihe ist die Suchmaschinenoptimierung (SEO). In diesem Jahr fand die SEO CAMPIXX, die in der Szene mittlerweile zu einem Kult-Event geworden ist zum dreizehnten Mal statt – diesmal nicht wie üblich im März, sondern mit Rücksicht auf das saisonabhängige Infektionsschutzgesetz erst im Sommer– aber wie gewohnt im Hotel Berlin am Berliner Müggelsee.

Auch in diesem Jahr waren wir auf der SEO Campixx 2021 in Berlin Köpenick vor Ort. Nachdem 2020 der erste Corona-Lockdown Mitte März für einen jähen Abbruch der Veranstaltung nach dem ersten Tag gesorgt hatte, konnte diesmal dank 3G alles ziemlich normal stattfinden. Bei der SEO CAMPIXX, einem Mix aus Konferenz, Vorträgen und Workshops, geben erfahrene und professionelle Referenten der Online-Marketing-Branche ihr Wissen weiter. Zwischendurch besteht in den halbstündigen Pausen viel Raum für lebhaften Austausch und reges Networking. Thematisch wird ein sehr breites Spektrum abgebildet, so dass sowohl Anfänger als auch Fortgeschrittene und Profis voll auf ihre Kosten kommen. Die gemeinsamen Mittagessen und Kaffeepausen bieten hervorragende Möglichkeiten, um mit anderen in Kontakt zu kommen und sich auszutauschen – und ein vielfältiges Unterhaltungsprogramm gibt es auch.

Worum ging es auf der SEO CAMPIXX 2021?

Das Programm der SEO CAMPIXX 2021 Summer Edition war – wie jedes Jahr – vollgepackt mit spannenden Themen. Wir haben zwei Tage lang so viele Sessions wie möglich besucht. Die aus unserer Sicht gehaltvollsten fassen wir hier zusammen.

„Core Web Vitals: What, How & Why?“ von Martin Splitt

Martin Splitt von Google Switzerland erklärte in seiner Session, was genau die noch relativ neuen Core Web Vitals von Google eigentlich wie und warum messen. Er unternahm dabei einen kleinen Ausflug in die Geschichte der Performance-Messung im Web. Er verwies auf die Unzulänglichkeiten herkömmlicher Metriken wie Time to First Byte (TTFB), Page Complete, DOM Content Loaded, Speedindex und erklärte die Begriffe First Contentful Paint (FCP) First Meaningful Paint (FMP) und Time to Interactive (TTI). Ein wichtiger Punkt dabei: Eine Reihe von nicht unerheblichen Problemen bei der Messung von Leistungsdaten von Seiten im Web trieben Google bei der Entwicklung der neuen Messmethoden um: Manche Werte sind schlicht zu ungenau oder zu sensibel, Manche Metriken bilden die UX nicht zutreffend ab und es besteht ein großer Unterschied zwischen Labordaten und echten Nutzerdaten.

Den mit den Core Web Vitals, die seit Mai 2021 ein neuer Ranking-Faktor sind, erhobenen Anspruch fasste er so zusammen: Es handelt sich dabei um Metriken, die dabei helfen sollen, die Performance zu verbessern, die erreichbare Ziele vorgeben und jährlich aktualisiert werden. Der leitende Gedanke liegt dabei in der visuellen Vollständigkeit einer Seite aus Nutzersicht. Die als Core Web Vitals zusammengefassten Metriken sind LCP (Largest Contentful Paint), FID (First Input Delay) für die Interaktivität und CLS (Cumulative Layout Shift) für den neu eingeführten Aspekt der visuellen Stabilität (kein Springen der Seite beim Laden).

In die möglichst genaue Bewertung der Page Experience mit diesen Metriken gehen Daten zu Page Speed und mobiler User Experience ein. Aber die angezeigten Messwerte sind nicht wirklich exakt, sollten also eher als ungefähre Indikatoren verstanden werden. In Abhängigkeit von der jeweiligen Datengrundlage bei der Messung können zudem abweichende Werte herauskommen, denn während Lighthouse auf dem eigenen Rechner läuft und für die Bewertung der Core Web Vitals Chrome-Nutzerdaten verwendet, wird Page Speed Insights auf einem Cloud-Server gehostet und greift auf Labordaten auf der Grundlage echter oder simulierter Cloud-Daten zurück. Für dieselbe Seite können auf diesen beiden Wegen daher sehr unterschiedliche Ergebnisse in den Core Web Vitals herauskommen.

Martins Vortrag entwickelte sich zu einer wirklich sehr informativen Session zu einem Thema, das weite Teile der SEO-Community in den vergangenen Monaten ziemlich beschäftigt hat.

„Hoch-konvertierender Organic Traffic auf Knopfdruck“ von Eico Schweins

In der Session von Eico Schweins drehte sich alles um die organische Produktsuche und Googles Free Product Listings: Wie werden Produkte für den Google Product Index fit gemacht? Wie lassen sie sich in Google Analytics sicht- und auswertbar machen? Mit welchen Hebeln können sie für noch mehr Traffic optimiert werden? Und was bringt das Ganze?

Dabei ging es sehr viel um unterschiedliche Schnittstellen, über die Google Daten bereitstellt: Search Console API, Analytics API, Natural Language API und Page Speed API. Was viele nicht so genau wissen: Mithilfe der Natural Language API trainiert Google seine KI, während darüber aus Nutzersicht aufschlussreiche Textanalysen (Positiv/Negativ-Bewertung und Syntax-Analyse) bereitgestellt werden. Während bislang alle APIs kostenlos zur Verfügung stehen, soll die Natural Language API künftig kostenpflichtig werden.

Ein weiterer wichtiger Hinweis von Eico: Die Search Console API liefert genauere Daten als die Webversion der Search Console. Während die API 5.000 Zeilen pro Request liefert, sind es in der Browservariante nur 1.000. Sehr aufschlussreich sind die API-Daten im Hinblick auf Seiten, die aus den Top-10 gefallen sind, das Thema „Kannibalisierung“ (SEO-Konkurrenz innerhalb einer Website) und anderes mehr.

Daten von Google sind eine sehr aufschlussreiche Ressource für die unterschiedlichsten Fragen rund um den eigenen Shop. Aber was ist mit Marktplätzen? Wie sieht es bei Amazon mit den Daten aus? Zunächst fällt auf, dass Amazon Daten von Kunden nur sehr spärlich nach außen gibt. Aber es gibt auch Amazon Marketplace Web Service, kurz Amazon MWS – und hier lassen sich die Kundendaten per API abrufen.

Diese Sessions voller tiefer Einblicke in die Welt der Schnittstellen für datengetriebene Web-Analytics im E-Commerce war unser zweites Highlight am ersten Tag der SEO CAMPIXX 2021.

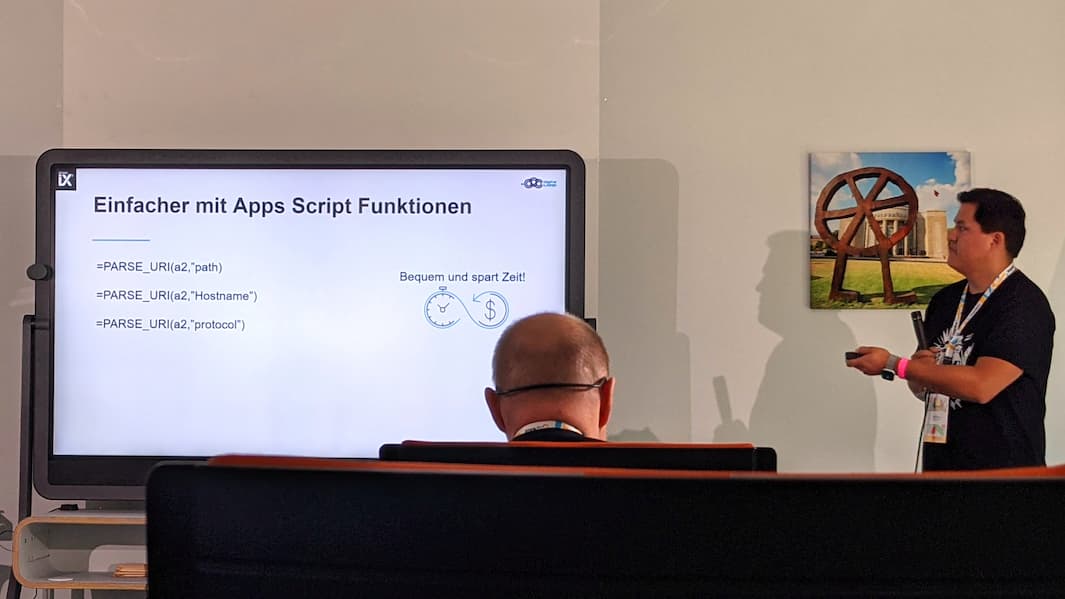

„Smartes SEO Alerting“ von John Muñoz

Am zweiten Tag verknüpfte John Muñoz seinen Vortrag eng mit der Praxis. Er erklärte den Aufbau eines smarten SEO-Alertings mithilfe von Google Sheets, Google Apps Script und BigQuery, um die eigenen Seiten und den Wettbewerb immer im Blick zu behalten.

Dabei wies John erst einmal auf den wesentlichen Unterschied zwischen Monitoring und Alerting hin: Ein Monitoring wird täglich oder wöchentlich durchgeführt, setzt einen Crawler mit Spider voraus und ist durch ein URL-Limit beschränkt. Die Ergebnisse werden als Report oder im Tool (Sistrix, Dawis, Datadog, Semrush) ausgegeben. Beim Alerting, das als Ergänzung für bestehendes Monitoring eingerichtet werden sollte, werden dagegen Checks im Minutentakt durchgeführt, es ist kein Spider notwendig und es gibt auch kein URL-Limit.

Custom-Checks sind möglich, während Ergebnisse als Benachrichtigung erscheinen und der Fokus auf schneller Ad-hoc-Reaktion liegt. Tools für effektives Alerting sind Pingdom und Dynatrace.

Überwacht werden sollten im SEO-Alerting:

-

Rankings, Positionen

-

HTTP-Header

-

Fehler im Attribut hreflang (ein gutes Tool dafür gibt es hier)

-

Gzip-Komprimierung

-

Sitemap (Erreichbarkeit, Fehler aus GSC)

-

Seitengrößen (in MB)

-

Metadaten

-

Code für Schema.org/JSON-LD

-

Seiten-Performance

Zum Sammeln und Aufbereiten der Daten braucht es Supermetrics oder UrlFetchApp und zum Auslösen der Checks sogenannte Trigger, die ähnlich wie Cronjobs funktionieren, aber keinen Server voraussetzen. Das Alerting via E-Mail lässt sich schließlich einfach mit Gmail umsetzen.

Und am Ende stellte John noch das auf JavaScript basierende Google App Script, die Plattform für die zielstrebige Entwicklung eigener Apps in Google Workspace mit aktiver Community und API vor. Mit diesem enorm leistungsfähigen Instrument lässt sich dann auch ein Alerting POC (Point-of-Care) umsetzen.

„Google Shopping Webseiten & Feed für kostenlose Listings optimieren“ von Veronika Prokofjeva

Vor dem Hintergrund mehrjähriger Erfahrung mit bezahlten Produkt-Listings erklärte Veronika Prokofjeva in ihrem Vortrag, wie SEO-Experten Produktdaten für organische Produkt-Listings optimieren müssen: Welche Voraussetzungen gibt es für die Ausspielung? Was genau lässt sich wie optimieren? Wie wird die Performance im Vergleich zum Paid Traffic ausgewertet? Ein sehr wichtiges Thema für alle, die im E-Commerce davon profitieren wollen, dass Google derzeit organische Produkt-Listings in Google Shopping ausspielt.

Grundsätzlich ist die Aufteilung der Shopping-Ergebnisse klar: Bezahlte Angebote werden weiter oben angezeigt, darunter folgen dann kostenlose Produkt-Listings ohne die Auszeichnung „Anzeige“. Zusätzlich zum Shopping-Tab können Produkte in der Google Bildersuche erscheinen, sind bisweilen bei Google Maps auffindbar und werden auch in den Ergebnissen in Google Lens platziert – mit einem Hinweis auf Shopping. Google spricht von 70 Prozent mehr Klicks über den Shopping-Tab und von 130 Prozent mehr Impressions. Echte Zahlen sehen Veronika zufolge allerdings etwas anders aus.

Gleichwohl: Die Gründe dafür, als Shopbetreiber diese Möglichkeit zu nutzen, liegen auf der Hand: Mithilfe von organischen Produkt-Listings lässt sich zusätzlicher Traffic direkt über die Produktseiten generieren und es lassen sich Produkte bewerben, die im Pay-per-Click (PPC) nicht funktionieren. Ein sinnvolles Vorgehen ist es, die eigenen Produkte über organische Produkt-Listings zu testen und dann gegebenenfalls Top-Performer für das PPC-Advertising zu identifizieren. Davon unabhängig betonte Veronika aber: Der „organische Weg“ zu Google Shopping lohnt sich auch für Unternehmen, die Google Ads Shopping noch gar nicht nutzen. Zudem ist zu beobachten, dass kostenlose Placements inzwischen auch für Produktkategorien wie Flüge und Hotels verstärkt genutzt werden. Das ist wenig überraschend, zumal sich auf diesem Weg noch weitere positive Signale an Google senden lassen: Google Kundenrezensionen, Seitenladezeit und so weiter.

Zur Frage nach den Voraussetzungen nannte Veronika zwei Punkte: Erstens müssen die Richtlinien von Google beachtet werden, und zweitens müssen das Produkt-Markup implementiert und der Produkt-Feed im Google Merchant Center hinterlegt sein, wobei der Feed mindestens fünf Attribute enthalten muss.

Die Attribute zur Optimierung für den Produktfeed sind:

-

Titel (Länge, Keywords, Sprache, Super, Reihenfolge) Hersteller + Produktname/Hauptkeywords + Attribut 1 + Attribut 2

-

Beschreibung (Länge, Keywords, USPs) Hauptkeyword + Nebenkeywords + Attribute

-

Farbe (Formulierung) Grapefruit > rot, Zimt > braun, Grey > grau

-

Google Produktkategorie (Best Practice: Tiefste mögliche Ebene, statt nur die übergeordnete)

-

Produkttyp von breit zu spezifisch: Autopflege > Motoröle > Synthetische Motoröle, Keywords mit Suchvolumen integrieren (3 bis 5 Stück)

-

Bilder (Quantität und Qualität) Lifestyle bei Wohnen, andere Bildwinkel, Produktdetails, bei Herstellerbildern ggf. spiegeln, zuschneiden – sichtbar von der Masse abheben

-

Sonderangebote (Preis, Lieferung) Attribut sale_price oder extra Feed mit percent_off

Die Auswertung der Performance läuft dann über das Google Merchant Center und lässt sich durch entsprechendes Taggen auch über utm-Parameter in den Statistiken im eingesetzten Analytics Tool für den Shop nachvollziehen. Dazu empfahl Veronika einen Blogpost von Search Engine Land.

Was gab es sonst noch?

Natürlich gab es noch viele, viele weitere Sessions, die ausgesprochen spannend waren. Wir haben uns zum Beispiel noch über Best Practices für den Bereich YMYL (Your Money Your Life) informiert, haben uns den Talk „Was wird aus SEO? Ausblicke für die SEO Industrie“ angehört und waren in Sessions zu den Herausforderungen von internationaler (und sprachenübergreifender) Suchmaschinenoptimierung, zu SEO-Audits und zu agilen Relaunch-Projekten mit Scrum und SEO. – Aber das alles war ja nur ein Ausschnitt aus dem vielfältigen und hochkarätigen Programm.

In einem Satz: Die SEO CAMPIXX 2021 hatte es mal wieder in sich – und wir sind im kommenden Jahr auf jeden Fall wieder dabei.